-

La nanotechnologie sauvera-t-elle la planète ?

La compagnie Nanosolar, appuyée financièrement par les fondateurs de Google, prévoit de construire dans la Silicon Valley la plus grande usine de fabrication de cellules solaires au monde. Ces cellules ne seront pas au silicium mais exploiteront la technologie cuivre-indium-sélénium (CIS) qui nutilise quune couche active extrêmement fine, une caractéristique qui rend ces cellules peu gourmandes en matériaux de fabrication et facilement adaptables aux supports flexibles. Cest un procédé novateur (1) issu de la nanotechnologie qui a permis de fortement rentabiliser la production, une rentabilité qui aura pour conséquence de faire baisser le prix du kWh solaire. Cette percée est un signe révélateur du potentiel industriel des nanotechnologies dans le domaine énergétique, il préfigure probablement une nouvelle ère pour notre gestion de lénergie. Il ne fait plus guère de doutes aujourdhui que lutilisation outrancière de lénergie fossile est devenue une menace imminente pour léquilibre de notre biosphère. Pas de doute non plus sur la nature de la « délivrance » qui viendra dune avancée technologique déterminante capable de produire une énergie propre et sûre à moindre coût. Mais de quelle nature sera cette innovation ?

On a beaucoup parlé ces derniers temps de la fusion nucléaire (programme Iter), mais les difficultés techniques à surmonter pour maîtriser cette énergie sont colossales, si bien que de telles centrales ne verront probablement pas le jour avant la seconde moitié du siècle. On a également parlé daméliorer puis de multiplier les centrales nucléaires classiques, mais leurs coûts en terme de maintenance, de gestion des déchets, de démantèlement et de risques limite fortement leur prolifération. Plus accessibles sont les petites unités de productions dénergie renouvelable comme les parcs éoliens ou les fours solaires, mais le nombre considérable de ces petites unités quil serait nécessaire de construire est exorbitant (sans doute plus de dix mille, rien quen France), ce qui est difficilement gérable et fort coûteux en espace et en matériaux de fabrication.

En fait, la révolution technologique la plus prometteuse dans un futur proche nappartient pas au domaine des grosses ou moyennes structures mais plus probablement à celui des nanostructures. La nanotechnologie (associée à la chimie, voire à la biologie) connaît en effet une telle progression quelle pourrait bien dépasser celle de la physique lourde et aboutir prochainement à des microcomposants (utilisables en quantités astronomiques) capables de produire et de stocker lénergie solaire aussi efficacement que des cellules biologiques spécialisées. Lutilisation des nanostructures permettrait ainsi une grande flexibilité et une grande économie de matériaux car une simple couche dun micromètre déléments actifs est théoriquement suffisante. Avec son projet dusine, la compagnie Nanosolar vient de montrer quil est désormais tout à fait possible de trouver, dans ce domaine, des solutions technologiques associant performance et coût de production, dès lors le marché des cellules photovoltaïques pourrait bien connaître prochainement une explosion semblable à celle qui secoua en son temps la microinformatique.

Vers quoi pourrait nous mener cette révolution ? Si le nombre dunités individuelles de production délectricité solaire parvient un jour à égaler ou à dépasser celui des micro-ordinateurs, et si nous trouvons des solutions viables pour le stockage de cette énergie, on pourrait sacheminer vers une transformation complète de notre gestion énergétique : dune part notre consommation sera à 100% électrique, et dautre part notre réseau passera dun système centralisé vers un système décentralisé, cest-à-dire quà linstar de linformation aujourdhui, lélectricité pourra séchanger et se réguler via un réseau électrique de type Internet.

Notons que la nature, qui a la réputation dêtre parfaitement optimisée, gère son énergie de façon similaire : lénergie du soleil est en effet convertie en énergie chimique par photosynthèse dans une infinité de petits générateurs individuels (les plantes, dont les feuilles sont des sortes de panneaux solaires), cette énergie chimique est ensuite stockée en partie dans la plante, sous forme de glucides, et en partie dans latmosphère sous forme de molécules doxygène afin de la rendre accessible à tous les êtres vivants (réseau aérien).

Mais avant den arriver là, de nombreux progrès restent encore à faire. Pour y parvenir, rien de tel quune recherche dynamique et inventive comme celle qui anime actuellement le petit monde de la nanotechnologie. Un peu partout, des chercheurs parviennent en effet à trouver des solutions de stockage et de production dénergie toujours plus efficaces et originales. Sur le stockage on peut citer par exemple lutilisation étonnante de bactéries comme catalyseur dans les piles à hydrogène (2), ou cette innovation encore plus prometteuse qui consiste à utiliser des nanotubes pour créer des supercondensateurs (3). Pour la production délectricité solaire, citons le cas remarquable de cette « peinture photovoltaïque » contenant des polymères (4) ou encore ces cellules solaires fonctionnant grâce à des protéines dépinard (5). Ne doutons pas que lémergence de solutions économiquement viables ne soit plus quune question de temps...

Voyons maintenant la pertinence quantitative dune telle décentralisation de lénergie. Prenons les chiffres de la consommation énergétique totale dun pays développé comme la France (6) :

Energie primaire totale utilisée (secteur énergétique compris) : 135 kWh/jour par habitant

consommation finale énergétique (hors secteur énergétique) : 80 kWh/jour par habitant

La différence vient essentiellement du très faible rendement des centrales électriques. Avec une énergie renouvelable comme le soleil, des véhicules électriques et une meilleure isolation des bâtiments, il serait théoriquement possible de diviser par deux lénergie totale consommée en France, passant de 80 kWh/jour par habitant à seulement 40 kWh/jour par habitant.

Lensoleillement moyen en France est de 4 kWh/m2 par jour (de 2 à 7 kWh/m2 dans le monde), il suffit donc, toujours en théorie, que chaque être humain réserve une surface dau moins 10 m2 pour collecter lénergie solaire. Dans la pratique la rentabilité des futurs panneaux solaires nexcédera probablement pas les 50% (il est actuellement de 36% dans les laboratoires), ce qui implique une surface dau moins 20m2 par personne. Il se trouve que cette surface est du même ordre de grandeur que la surface de toiture par habitant (linverse de la densité dune ville comme Paris donne 50m2 par habitant, soit environ 20m2 de toiture en tenant compte de la voirie). Quantitativement parlant, cette perspective nest donc pas une utopie.

Reste que pour quune telle entreprise réussisse, il sera nécessaire de moderniser profondément lindustrie du bâtiment : elle devra notamment sadapter pour intégrer complètement les nouveaux matériaux dans ses structures, que ce soit dans le domaine de la production délectricité photovoltaïque (tuiles, vitrage, peinture...) ou dans celui du stockage (pile à combustible ou supercondensateurs intégrés dans les murs et les planchers des bâtiments).

Si la quantité dénergie ainsi collectée nest toujours pas suffisante, et dans lhypothèse quon aboutisse effectivement un jour à des matériaux photovoltaïques aussi malléables quune peinture, il faudrait étendre cette initiative à toutes les infrastructures de la voirie et, à la limite, pourquoi ne pas imaginer lasphalte photovoltaïque ? Les routes de France représentent une surface de lordre de 4 milliards de m2, en termes dénergie solaire cela représente en pratique plus de 150kWh/jour et par habitant, soit plus de trois fois nos besoins énergétiques... De plus un tel système ferait dune pierre deux coups puisque le réseau électrique et le réseau routier se confondraient (sans parler du fait que la surface dun réseau routier est proportionnelle aux besoins énergétiques dun pays).

Pour conclure, tournons-nous vers la planète Mars : actuellement il y a sur cette planète deux véhicules robotisés qui explorent sa surface depuis plus de trois ans, alors que leur espérance de vie initiale était estimée à seulement trois mois. La raison de ce succès réside dans deux innovations issues de la nanotechnologie : la première est la grande efficacité des panneaux solaires, la seconde est un matériau isolant aérogel qui permet aux robots de ne rien gaspiller de cette énergie. Il était prévu pour le robot de la seconde génération dembarquer un petit réacteur nucléaire, mais devant le succès phénoménal de la solution solaire, les décideurs de la Nasa hésitent (7)...Ces robots martiens seraient-ils en train de nous dicter la marche à suivre pour la gestion énergétique de notre planète ?

-

Les nanotechnologies

Les nanotechnologie ca a l'air compliqué mais en fait... c'est vraiment compliqué ! Heureusement, une séparation entre fantasme et réalité est (encore) possible. Restons vigilants car les similitudes avec l'amiante ou les OGM n'est pas fortuite.Le terme nanotechnologie a été employé pour la première fois en 1974 par le Japonais Norio Taniguchi, pour désigner l'ensemble des techniques ayant pour but de concevoir, fabriquer et utiliser des structures à l'échelle du nanomètre (milliardième de mètre).

A l'origine, ces techniques regroupent des processus de réorganisation de la matière atome par atome, ou molécule par molécule, selon deux orientations complémentaires : le top down et le bottom up.

- La première fait référence à la voie dite descendante, qui consiste à travailler un matériau à l'échelle macroscopique pour tenter d'en tirer un objet miniature (par analogie : obtention d'un silex à partir d'une pierre, d'un cure-dent à partir d'un arbre, ou des éléments d'un microprocesseur à partir d'une plaquette de silicium);

- la seconde correspond à la voie dite ascendante, ou de construction sur le modèle du Légo, et implique de pouvoir observer, isoler et manipuler les atomes et les molécules pour les organiser selon la structure souhaitée. C'est essentiellement cette deuxième voie qui est explorée par les recherches dans les nanosciences aujourd'hui.

A ces définitions, quelque peu ésotériques pour le citoyen lambda, correspond une réalité empirique du point de vue de la recherche scientifique, des usages sociaux et de la mise sur le marché de nouveaux produits étiquetés "nano", mais également une idéologie fantasmatique proche du transhumanisme.

Le saviez-vous ?

Bain doucheUn bain nécessite l'utilisation de 150 litres d'eau, contre 50 litres pour une douche de 5 minutes.

La mise en regard de la réalité et du fantasme est indispensable pour permettre à chacun d'adopter une attitude responsable au quotidien, et de prendre position de manière éclairée dans la controverse.Car même si le développement des nanotechnologies s'accompagne de promesses d'âge d'or et de bonheur collectif ou individuel, il existe de nombreuses raisons de s'opposer à leur prolifération.

- Tout d'abord à cause des fréquentes usurpations dans l'utilisation du préfixe nano (qu'il s'agisse des slogans publicitaires ou des intitulés des programmes de recherche scientifique),

- ensuite parce que les risques sanitaires et environnementaux de l'emploi des nanoparticules à l'échelle industrielle sont mal connus (en particulier les risques liés à leur caractère invasif : les nanoparticules se faufilent partout, peuvent traverser la barrière cutanée, être inhalées, etc.),

- enfin parce que les nanotechnologies servent à faire la guerre, tant du point de vue strictement militaire qu'économique.

Brève histoire des nanotechnologies

L'histoire des nanotechnologies est indissociable de celle des instruments ayant permis l'observation, la mesure et la manipulation à l'échelle atomique dans la deuxième moitié du XXe siècle.

Quelques dates marquantes

1959 : Le physicien Richard Feynman prononce son fameux discours sur les nanosciences à la société américaine de physique « There is plenty of room at the bottom ». Pour illustrer les enjeux des nanosciences, celui-ci avance la possibilité de faire tenir les 24 volumes de l'Encyclopedia Britannica sur une tête d'épingle.

1970 : Invention du principe du Bottom up, véritable révolution dans l'histoire des techniques, qui consiste à concevoir et fabriquer des structures miniatures en partant du niveau atomique. On peut considérer que c'est ce renversement dans la façon de penser la production des objets, qui marque l'avènement réel des nanotechnologies. Apparition de la technique de vectorisation des médicaments, grâce à l'utilisation des liposomes.

1974 : Première utilisation du terme « nanotechnologie » par le Japonais Norio Taniguchi de la Tokyo Science University.

1981 : Invention du microscope à effet tunnel (ou à « champ proche »), qui permet non seulement d'observer les atomes sur des surfaces conductrices ou semi-conductrices, mais également de les déplacer un par un.

1986 : Création d'un nouveau microscope à champ proche, qui étend les observations et manipulations aux matériaux non-conducteurs. Année de publication de l'ouvrage prophétique de Kim Eric Drexler « Engines of création ».

1989 : Première manipulation de la matière à l'échelle atomique, à l'aide du microscope à effet tunnel. Donald Eigler parvient à déplacer 35 atomes de xénon pour dessiner les initiales d'IBM sur une surface de nickel.

1998 : Découverte d'un rotor moléculaire, qui ouvre la voie (théorique) à la conception de moteurs moléculaires et, pourquoi pas, à celle de « nanorobots ». Lancement par Bill Clinton du programme National Nanotechnology Initiative, doté de 497 millions de dollars et qui fait des nanotechnologies une priorité nationale. Un quart de ce budget est consacré au développement de nanotechnologies militaires.

1999 : Construction d'un nanomoteur de moins de 100 nm. Abandon progressif de la voie descendante.

2001 : Construction d'une brouette moléculaire, la « nanobrouette », munie de deux roues, d'un châssis et de deux poignées, que l'on peut manipuler avec la pointe d'un microscope.

2004 : Premier rapport gouvernemental britannique sur les nanosciences et les nanotechnologies, qui vise à lancer le débat public sur les nano, leurs opportunités et leurs incertitudes.

2006 : Inauguration du pôle Minatec, le 2 juin à Grenoble. C'est le plus grand pôle européen consacré aux applications des micro et nanotechnologies.

Les applications, entre fantasme et réalité

Les applications des nanotechnologies aujourd'hui ressortissent de trois domaines majeurs : militaire, médical et commercial.

Applications commerciales des nanotechnologies

Raquettes de tennis, tests de grossesse, mémoires flash des lecteurs mp3 ou crèmes solaires, la plupart des produits de consommation « nano » sont basés essentiellement sur des effets de surface, sur la modification de la résistance des matériaux ou sur l'accroissement de la capacité de pénétration des principes actifs.

La recherche sur les effets de surface conduit à la fabrication d'objets à texture rugueuse, imperméable, « easy to clean », « Lotus-effect », anti-trace de doigt, autonettoyante, anti-graffiti, anti-microbien, anti-brouillard, etc. En ce qui concerne les surfaces easy to clean, par exemple, l'objectif est de parvenir à modifier les propriétés du verre, du textile ou du ciment, de telle sorte que ceux-ci absorbent moins facilement les autres matières, tout en conservant leur propriété de transparence, de douceur ou de résistance.

Pour la crème solaire « translucide », on utilise l'oxyde de zinc ou l'oxyde de titane, qui sont des absorbeurs d'ultra-violet connus depuis longtemps, mais qui ont pour fâcheuse tendance de laisser des traces blanches sur la peau après application. Leur « avantage » à l'échelle nano est qu'ils n'absorbent plus la lumière visible, mais seulement les "UV. Certaines marques de cosmétique proposent également des crèmes à base de nanoparticules, ou dont les principes sont nano-encapsulés, en prétendant que cela améliore leur pouvoir couvrant ou pénétrant (les particules nanoencapsulées dans des liposomes pénètrent plus facilement la barrière cutanée).

Applications médicales des nanotechnologies

Les trois principales applications des nanotechnologies dans le domaine médical sont la vectorisation des médicaments, les puces adn et l'utilisation des quantum dots en bio-imagerie.

La vectorisation des médicaments est basée sur le principe d'adressage, qui consiste à encapsuler le médicament dans un nanovecteur (le plus souvent un liposome), de telle sorte que celui-ci ne délivre son principe actif qu'après avoir pénétré la cellule malade, et non pas durant son « chemin » via la circulation sanguine. L'objectif de l'adressage est donc une plus grande maîtrise de l'index thérapeutique, de manière à réduire la toxicité des médicaments, ainsi que les effets secondaires ou simplement à améliorer leur efficacité. Les puces à adn sont utilisées pour diagnostiquer des cancers. Les quantum dots servent de marqueurs en bioimagerie.

C'est sans doute dans le domaine médical que les utopies sont les plus prolifiques, cependant on est encore loin, même très loin des tissus autorégénérants ouvrant les voies de l'immortalité, ou des nanorobots qu'il suffirait d'ingérer pour une aventure intérieure thérapeutique.Applications militaires des nanotechnologies

On sait de les nanotechnologies intéressent l'Armée (un quart du budget colossale consacré à la recherche dans les nanotechnologies aux Etats unis est consacré à la défense). Textiles camouflants, uniformes communicants ou exosquelettes pourraient servir à « améliorer » conséquemment l'équipement des fantassins déjà suréquipés. Sans parler de l'avantage stratégique que représenterait la possession de nanodrones de la taille d'une libellule, indécelables, ou de nanocapsules de produit toxique qu'aucune barrière, qu'aucun masque à gaz ne pourrait arrêter...

On peut suivre Jürgen Altman qui classe les applications militaires des nanotechnologies selon trois catégories :- miniaturisation, allégement, accroissement de la résistance des équipements.

- utilisation de nouveaux matériaux nanostructurés.

- modification du métabolisme humain par hybridation, implants, puces et prothèses.

Concrètement, le passage à l'échelle nano devrait permettre de stocker et analyser toujours plus d'informations, d'équiper les missiles de nano-ordinateurs incorporés, d'implanter des capteurs sur les soldats pour suivre leur état de santé, de déclencher des alertes en cas d'agression ou de mort, ou des contre-mesures à visée curative (injection automatique d'antalgique, d'antiinflammatoire, etc.), ou encore de renforcer les blindages par adjonction de nanotubes de carbones.

Si certaines de ces applications ressortissent encore aujourd'hui du (mauvais) rêve, d'autres tel que le nanodrone « Libellule » financé par la DGA sont bien réels...Les risques sanitaires et environnementaux

Il n'existe à ce jour aucune étude concluante sur les dangers ou l'innocuité des nanotechnologies. En juin 2003, le gouvernement anglais a mandaté la Royal Society pour mener une étude indépendante, afin d'évaluer les impacts potentiels sur la santé et l'environnement des nanotechnologies. On peut toutefois pointer déjà quelques problèmes.

Certains effets pervers des nanomatériaux sont déjà apparus : dans le domaine de l'automobile, par exemple, le remplacement de pièces métalliques entrant dans la confection des carrosseries, par des matériaux faits de composants polymériques était censé alléger, en fin de parcours, le poids des véhicules et induire donc une réduction de la pollution émise lors des déplacements. Seulement, le recyclage des polymères étant plus compliqué que celui du métal remplacé, le problème semble avoir été simplement déplacé.

Par ailleurs, l'augmentation du ratio surface / volume propre aux nanoparticules accroît leur réactivité. Leur stockage demande donc des soins tout particuliers. En effet, les particules s'oxydent facilement, et cherchent sans cesse à s'agglomérer entre elles. Il faut donc les conserver dans un gaz inerte, ou en les enrobant d'une couche protectrice constituée de polymères ou de sels (couche qu'il faudra ensuite filtrer).

Une étude approfondie a été menée sur les risques sanitaires liés à la diffusion des nanomatériaux par Vicki L. Colvin (directrice du Centre de Nanotechnologie Environnementale et Biologique de l'Université de Rice).

Cette étude montre que, sous certaines conditions, les nanoparticules de moins de 50 nm ont tendance à infiltrer les cellules vivantes, sans qu'il soit possible de savoir comment celles-ci sont ensuite distribuées dans le corps. Les particules de tailles plus réduite encore, pourraient circuler de manière plus prolongée dans l'organisme, et même dans certains cas franchir la barrière hémato-méningée, ou sortir des vaisseaux sanguins pour se « promener » dans les fluides intercellulaires.Günter Oberdörster, professeur de toxicologie à l'université de Rochester, a étudié de son côté les effets des particules aériennes sur la santé. Sa conclusion est que les particules ultrafines (de moins de 100 nm) sont plus susceptibles d'entraîner des inflammations pulmonaires que les autres. Il existerait donc une corrélation entre le degré de toxicité et la dimension des particules inhalées.

Il est utile de rappeler que nous sommes régulièrement exposés à des particules ultrafines, celles émises par les pots d'échappement des véhicules motorisés. Il est cependant très probable que notre niveau d'exposition aux particules ultrafines augmente conséquemment avec l'émergence et l'utilisation à grande échelle des nanotubes de carbone dans l'industrie. L'effet de ces nanotubes, lorsqu'ils sont inhalés, prendrait la forme de nodules ou « granulomas », produits par l'organisme pour tenter d'isoler les nanotubes de carbones inhalés, nodules qui peuvent déboucher à terme sur des lésions pulmonaires.

D'autres études, notamment celles menées par D. Warheit, ayant débouché sur des conclusions contradictoires, il serait bon que soit mis en oeuvre un programme de recherche concernant l'impact de l'inhalation des nanotubes de carbone sur le système respiratoire.

-

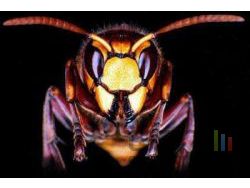

Selon un quotidien israëlien paru vendredi, l'état éponyme utilise la nanotechnologie pour créer des robots de la taille d'un frelon, qui seraient capables de pister, de photographier et de tuer les cibles qui lui seraient assignées.

Le robot volant, connu sous le nom de " bionic hornet " ou frelon bionique, serait a priori capable de se frayer un chemin dans de tous petits endroits, afin de pouvoir réaliser de véritables opérations de frappes chirurgicales, avec par exemple la neutralisation d'ennemis auparavant difficilement atteignables, comme des soldats équipés de lance-roquettes, selon le quotidien Yedioth Ahronoth.

Une technologie en devenir

La nanotechnologie et la robotique sont décidément au coeur de nombreuses actualités, comme nous vous en parlions ici, ou là, et comme nous vous en parlons aujourd'hui.

Le " frelon " nanotechnologique est un des projets parmi ceux que développent les scientifiques militaires du pays. D'autres projets existent, tels ces gants modifiés qui augmenteraient puissamment la force du porteur (qui a dit iron man') ainsi que des senseurs miniaturisés à l'extrême, afin de se prémunir contre les attaques suicides qui sont fréquentes là-bas.

Selon Shimon Peres, vice-premier ministre, la recherche intègre de fait pleinement la nanotechnologie dans le champ des possibilités offertes au département de la sécurité israëlienne, qui fera en sorte de trouver des solutions pour résoudre les problèmes que l'armée ne peut régler de manière conventionnelle.

La guerre robotique deviendrait-elle une réalité'

" La guerre au Liban nous a montré combien il était primordial de s'équiper en armes beaucoup plus petites. Il n'est absolument pas logique d'envoyer un avion qui coûte 100 millions de dollars pour s'occuper d'un seul terroriste suicidaire. Nous avons donc décidé de commencer à construire des armes bien plus adaptées à la situation et assez futuristiques " a expliqué Peres dans les colonnes du quotidien.

La guerre de 34 jours qui eu lieu au Liban cet été s'est finie par un cesser-le-feu organisé par les Nations Unies. La guerre a fait plus de 1,200 victimes libanaises, principalement des civils et 157 israëliens, la plupart militaires.

Selon les estimations annoncées, les prototypes de ces nouvelles armes seront disponibles dans trois ans. Effet d'annonce politique, ou véritable avancée dans la technique ' Le futur nous dira ce qu'il en est vraiment.De lusage militaire des nanotechnologies

Louis Laurent

Physicien

Aux Etats-Unis, le domaine de la défense absorbe un quart des financements de l'Initiative nationale sur les nanotechnologies. Un livre récent du physicien allemand Jürgen Altmann analyse les possibles applications militaires des nanotechnologies en couvrant un large spectre, des applications les plus réalistes aux plus folles. Louis Laurent propose une compilation des perspectives que Jürgen Altmann décrit dans son ouvrage.

Jürgen Altmann

© Université de DortmundJürgen Altmann, physicien à lUniversité de Dortmund, a récemment publié l'une des premières analyses prospectives d'ampleur consacrées aux applications militaires des nanotechnologies (1). Il y dépeint en particulier les programmes qui sont financés aux Etats-Unis dans le cadre de la « National Nanotechnology Initiative », un projet fédéral américain de lordre d'un milliard de dollars, dont environ 25 % au titre du département de la Défense (2).

Particulièrement instructive est lanalyse que brosse Jürgen Altmann des applications militaires des nanotechnologies à partir de la littérature existante et des programmes de recherches américains, comme ceux de la DARPA, la Defense Advanced Research Projects Agency (3). On pourrait classer les applications quil évoque en trois catégories : les retombées de recherches non spécifiquement militaires, les développements de nature militaire, et des perspectives plus spéculatives.

Les systèmes embarqués par des avions de chasse profiteront largement de la miniaturisation des dispositifs de communication et de traitement de l'information.

© Air Force Musicians AssociationDes ordinateurs de la taille d'un dé à coudre

Première application : les retombées de recherches non spécifiquement militaires. Cette première catégorie, comprend les utilisations de technologies civiles pour linformation et la communication, les matériaux, les capteurs, la gestion de lénergie. Dans la plupart des cas, il sagit dévolutions estimées par Altmann à un horizon de cinq à dix ans.

Dans le domaine des technologies de linformation, lindustrie de lélectronique va produire ces vingt prochaines années des circuits de plus en plus performants en terme de puissance de calcul, et cela à un rythme soutenu. On peut imaginer que naîtront de petits calculateurs de la puissance dun ordinateur de bureau actuel, mais enfermés dans des centimètres cubes voire des millimètres cubes. Ces calculateurs pourraient alors se généraliser, par exemple dans tout ce qui est logistique, les systèmes portés par le fantassin, mais aussi dans les munitions de petite taille qui pourraient ainsi acquérir des capacités de guidage accrues.

De même, cette évolution va mener à la prolifération de capteurs autonomes capables de calculer et de communiquer sans fil. Altmann précise toutefois que la miniaturisation rencontre des limites, par exemple le fait que, lorsquil sagit de communiquer à une distance utile, des antennes et des sources de puissance de tailles centimétriques deviennent nécessaires. Lapparition de petits écrans plats et souples, peu gourmands en énergie permettrait en outre de réaliser de nombreux systèmes de visualisation de linformation.

Au-delà de cette évolution « classique », des systèmes dinformation dun genre nouveau pourraient se développer et permettre laccroissement des puissances de calcul ou des capacités de stockage de linformation : nouveaux composants fondés sur le magnétisme, par exemple des mémoires magnétiques qui ne seffacent pas lorsquon coupe le courant, donc des ordinateurs instantanément prêts à lallumage ; systèmes optiques assurant des transferts rapides avec des débits qui se mesureraient en térabits (mille milliards de bits) par seconde, systèmes à basse consommation ; mémoires moléculaires avec des densités dinformation dix mille fois supérieures à celles des circuits actuels.

Le développement des puissances de calculs disponibles et des moyens de communication a pour corollaire de nouveaux logiciels. Ils peuvent concerner des simulations de champs de bataille virtuels à des fins dentraînement ou danalyse stratégique, mais aussi la gestion de la logistique. Dautres perspectives qui semblent à portée sont la capacité des machines à communiquer en langage naturel, les systèmes de traduction automatique, laccès à des données variées. A plus long terme, on peut imaginer des systèmes autonomes et intelligents.

Matériaux nanostructurés

Dans le domaine des matériaux et systèmes mécaniques, des additifs nanométriques seront utilisés tout dabord pour améliorer les propriétés des matériaux, par exemple pour répondre à des contraintes variées (les rendre peu inflammables, imperméables, conducteurs de lélectricité). La résistance mécanique des matériaux sera accrue. Jürgen Altmann évoque des composites à base de nanotubes de carbone ou des alliages métalliques nanostructurés qui pourront servir à réaliser des structures plus légères ou plus résistantes.

Concept d'un biocapteur électrochimique à base d'un microréseau de nanotubes de carbone, capable de détecter des molécules d'ADN ou de petites molécules.

© NasaEn défense, un domaine dutilisation privilégié est bien entendu le blindage. Altmann estime que lévolution la plus forte se fera dans le domaine des protections contre les projectiles légers (gilets pare-balle), les nanomatériaux nayant que peu defficacité contre des projectiles lourds. De même, des matériaux améliorés peuvent avoir un impact sur les armes, quil sagisse de projectiles plus pénétrants mais aussi de substituts aux métaux rendant les armes plus difficilement détectables. Un dernier domaine dapplication est celui des matériaux « intelligents », éventuellement inspirés du vivant : ils pourraient se déformer, exercer une force, sadapter, par exemple modifier leurs propriétés optiques dans le but de réaliser des camouflages. On peut imaginer des systèmes sophistiqués contenant de nombreux moteurs miniatures (bio-inspirés, matériaux simulant des muscles, moteurs électrostatiques, etc.) réalisant des mouvements complexes ou simplement plus robustes, la puissance motrice étant répartie dans le matériau et non pas centralisée sur un moteur.

Les nanotechnologies permettent par ailleurs de développer des capteurs de taille extrêmement réduite. Jürgen Altmann note quun détecteur de petite taille nest toutefois pas toujours aussi sensible quun détecteur plus grand et que la course à la miniaturisation napporte pas toujours un gain en performance. Cependant, il est probable que le nombre de détecteurs en usage va augmenter, qu'il s'agisse de systèmes de détection dagression, de localisation, à usage médical, de détection

Autonomie puissance dix

Une évolution en cours est la généralisation de capteurs « communicants », c'est-à-dire de systèmes autonomes, capables de transmettre par ondes le résultat de leurs mesures. En pratique, une portée raisonnable demande des systèmes centimétriques mais il existe des voies de miniaturisation plus poussée vers des systèmes millimétriques, voire submillimétriques, contenant divers types de capteurs (sismique, d'ondes sonores, chimique, de radiations) que lon « saupoudrerait » sur le terrain par milliers. La portée radio de tels systèmes étant très faible, linformation se déplacerait de proche en proche ou serait lue à distance, par exemple à laide dun laser.

Un autre domaine dapplication de ces capteurs est le soldat lui-même. Différents systèmes localisés à la surface du corps, voire implantés, permettraient de suivre son état de santé voire de donner lalerte ou déclencher des contre-mesures en cas dagression.

La gestion de lénergie est un terrain de jeu complémentaire. Selon Jürgen Altmann, les nanotechnologies peuvent permettre des avancées pour les sources dénergies de forte puissance, avec des piles à combustible de quelques dizaines de kilowatts pour les véhicules, comme pour les sources dénergie de faibles puissances (du microwatt à la centaine de watts), qui seraient destinées à rendre autonomes des systèmes portés par un fantassin, voire implantés dans son corps. Les techniques envisagées sont variées : énergie solaire, piles à combustible, chaleur du corps, glucose, etc.

Les matériaux énergétiques (explosifs, propulsion) ne sont pas en reste : il devient possible de réaliser des milieux dans lesquels les échanges dénergie sont optimisés par des mélanges intimes de carburant et comburant, des puissances programmables, des molécules « sur mesure ». Altmann évoque toutefois des augmentations modestes des capacités énergétiques (moins dun facteur deux).

Le futur combattant disposera de multiples capteurs et dispositifs d'assistance qui le rendront moins vulnérable et plus efficace.

© National Institute of Standards and TechnologyDe la tenue intelligente au micromissile

Selon Jürgen Altmann, toutes ces pistes naboutiront pas nécessairement à des systèmes utiles à des fins militaires, en particulier en raison des limitations en puissance, en mobilité, et en charge utile des microsystèmes. Mais les possibilités sont nombreuses et variées : tenues « intelligentes » capables dinteragir avec le corps du soldat, de changer dapparence et offrant une perception accrue des agressions extérieures, une meilleure protection, voire quelques soins médicaux (compression de plaie, attelle en cas de fracture, injection de médicaments) ; munitions ou missiles plus petits à cause de lallègement des structures et de la plus forte puissance des propulseurs mais surtout du fait de laugmentation de la précision de la trajectoire qui permet de diminuer la charge explosive transportée ; véhicules plus légers, plus puissants et surtout autonomes quil soient terrestres, marins ou aériens (surveillance, logistique, attaque), etc.

Jürgen Altmann discute également limpact que pourrait avoir lamélioration des explosifs et des matériaux sur les armes nucléaires. Il avance la possibilité de réduire la masse de matériau fissile nécessaire mais ne pense pas que cela induirait un changement qualitatif de ce type darmes. De même, limpact que ces techniques pourraient avoir dans le domaine spatial ne paraît pas anecdotique. Altmann évoque en particulier la possibilité de réaliser des microsatellites dune dizaine de grammes, éventuellement associés en essaims. Ils pourraient être mis en orbite par des fusées de taille modérée lancées à partir dun avion. Ces satellites seraient capables de détection (il sagit dune extension du cas des capteurs discutés ci-dessus), pourraient inspecter ou réparer dautres satellites, mais aussi constituer des armes anti-satellite.

Une deuxième catégorie de développements, plus spécifiquement militaires, rassemble des réalisations plus spéculatives et en tout cas de plus long terme (dix à vingt ans). Elles constituent souvent une rupture avec lexistant et posent des problèmes déthique, voire correspondent à des armes explicitement interdites par la Convention sur les armes chimiques (4) et celle sur les armes biologiques (5).

« Amélioration » de lhumain, microrobots et hybrides animal-machine

Des systèmes localisés dans le corps ou à sa surface pourraient à long terme donner de nouvelles possibilités au soldat. Des capteurs - actionneurs pourraient injecter, en fonction des circonstances, diverses substances capables daugmenter la résistance du combattant aux agressions, de soigner voire de modifier son comportement. Des connexions entre des micromachines et le système nerveux pourraient augmenter la rapidité dune action, voire implémenter de nouveaux sens par branchement de capteurs. Altmann rapproche ces perspectives des recherches médicales actuelles destinées à guérir des lésions graves de la rétine ou de la moelle épinière. Une troisième catégorie daction consiste à améliorer les capacités mécaniques du corps par exemple en renforçant les os, les muscles ou en développant un exosquelette.

Robolobster, robot biomimétique sous-marin mis au point au Northeastern University´s Marine Science Center (Nahant, Massachusetts). Les nanotechnologies apporteront miniaturisation, légèreté et résistance aux robots à usage militaire.

© U.S. Navy, photograph by John F. WilliamsJürgen Altmann discute la possibilité de réaliser des microrobots de taille inférieure à 5 millimètres voire submillimétriques. Il mentionne les difficultés techniques soulevées par un tel concept, notamment leurs limites en ce qui concerne lénergie, les communications et les déplacements qui ne pourraient être que limités. Sur ce dernier point, divers modes de déplacements pourraient être envisagés (flagelle, pattes, ondulations, vent ), mais aussi transport par des projectiles ou des véhicules plus gros. De tels robots serviraient avant tout à des opérations de surveillance, mais pourraient être aussi utilisés comme armes ou moyens de sabotage, soit en mode isolé soit en essaim.

Combiner du vivant avec des systèmes est une autre grande perspective. Une première approche consiste à équiper un petit animal (rat, insecte) d'un système de contrôle permettant de le « télécommander » voire daugmenter ses capacités. Jürgen Altmann évoque ainsi les travaux de léquipe de Sanjiv Talwar (Neural and Behavioral Science Program, State University of New York Downstate Medical Center) sur les « ratbots » publiés en mai 2002 dans la revue Nature (6). De même, des morceaux dorganes sensoriels (souvent plus performants que les capteurs artificiels actuels) pourraient être implantés dans des microrobots. Altmann évoque avec raison le flou qui peut sinstaurer entre le vivant et le non-vivant dans un tel contexte.

Armes chimiques et biologiques

Jürgen Altmann discute la possibilité dassocier des toxiques chimiques ou des espèces pathogènes à des nanosystèmes capables par exemple dassurer un stockage plus sûr de ces substances mais aussi de les transporter sur des cibles spécifiques, voire avec un certain degré de sélectivité. Cependant les « armes ethniques » (qui viseraient des ethnies particulières ou leurs ressources) lui semblent actuellement peu plausibles.

Une dernière catégorie dapplications est, comme lindique Jürgen Altmann, beaucoup plus spéculative. Elles sont associées à des capacités de manipulation de la matière à léchelle atomique, rêvées par Eric Drexler dans les années 1980.

La littérature évoque la possibilité de réaliser un jour des nanorobots capables de réaliser certaines tâches en manipulant la matière à léchelle moléculaire mais aussi de se répliquer à limage du vivant. Ces « nanobots » pourraient être utilisés pour construire en un temps record des équipements militaires y compris nucléaires, et cela à partir de ressources variées disponibles par exemple dans le sol (minéraux, carbone, ).

Des armes de destruction massive ?

Des systèmes de très petite taille doués de capacités proches de celles du vivant en terme dautonomie, de possibilités de se reproduire, de perception de lenvironnement, voire de calcul, ouvriraient la porte à de nombreuses armes dun type nouveau. Elles ne remplaceraient pas les armes « classiques », qui se caractérisent en général par une grande libération dénergie, mais agiraient en pénétrant dans le corps, en modifiant le métabolisme ou en causant des dégâts éventuellement mortels, en attaquant des infrastructures (abrasion, corrosion, courts-circuits), ou encore en détruisant les moyens de communication ou les systèmes informatiques. Jürgen Altmann évoque des variantes sélectives agissant sur des cibles précises ou au contraire des versions destinées à la destruction massive.

Très brièvement, Jürgen Altmann spécule sur la possibilité de stocker dans des systèmes de très petites tailles de lantimatière produite par un accélérateur de particules. Des pièges miuscules permettraient de stabiliser des nuages danti-atomes en les faisant léviter à labri des collisions avec des atomes, ce qui aurait pour effet de les annihiler. Si l'on arrivait un jour à en piéger un nombre suffisant (un microgramme dantimatière représente 44 kilogrammes de TNT), on pourrait réaliser par exemple des bombes ou des amorces pour des bombes thermonucléaires qui pourraient alors être miniaturisées.

Un texte qui interpelle, à nen pas douter essentiel pour le dialogue international sur les nanotechnologies qui est en cours dinstauration.

Références

(1) J. Altmann (2006) Military nanotechnology: Potential applications and preventive arms control, Editions Routledge, Londres et New York , 2006

(2) http://www.nano.gov/html/about/funding.html

(3) http://www.darpa.mil/body/off_programs.html

(4) (http://www.un.org/Depts/dda/WMD/cwc/

(6) Voir M. Sigman (2004) Commander une machine par la pensée, Le Monde diplomatique, septembre 2004.

http://www.monde-diplomatique.fr/2004/09/SIGMAN/11452

-

De très nombreux experts ont urgemment demandé que soient lancées des investigations concernant les éventuels dangers qui pourraient se présenter dans l'usage et le développement de la nanotechnologie, qui doivent être identifiés et éliminés, afin que le public soit rassuré quant à l'utilité réelle de cette avancée scientifique.

La communauté scientifique travaillant sur le domaine de la nanotechnologie n'est pas encore sur le premier plan de la scène étant donné les applications encore très restreintes de leurs expérimentations.

La communauté scientifique travaillant sur le domaine de la nanotechnologie n'est pas encore sur le premier plan de la scène étant donné les applications encore très restreintes de leurs expérimentations.

Traiter le problème à la racine

Si le public doit être convaincu de l'utilité des recherches menées, il doit d'abord en saisir toutes les conséquences et, selon les opinions de certains chercheurs, promouvoir les bienfaits au niveau médical ou informatique de leur champ de recherche ne sera pas une mince affaire.

Le potentiel nanotechnologique ne pourra prendre toute sa puissance que lorsque les informations concernant les éventuels dangers de cette technologie et les facons de les éviter auront été clairement expliqués au public.

Andrew Maynard, du Woodrow Wilson International Center for Scholars de Washington ainsi que 13 autres experts du monde entier veulent avertir les autorités compétentes afin que celles-ci puissent anticiper et ne plus perdre de temps.

" Si le public n'a plus confiance en l'engagement pris par les gouvernements, les entreprises et la communauté scientifique en ce qui concerne la recherche systématique de tous les dangers possibles contenus dans cette technologie, alors le potentiel immense de la nanotechnologie serait gâché. Nous ne pouvons donc pas accepter cela " ont expliqué ces scientifiques dans la revue Nature.

Les nanotechnologies regroupent plusieurs domaines tels que l'optique, la biologie, l'électronique, la mécanique et la chimie qui manipulent des objets d'une taille de l'ordre du nanomètre (10-9 mètre). Le terme est parfois utilisé par extension pour les microtechnologies.

Elles se sont développées avec l'avènement d'outils tels que le microscope à effet tunnel et le microscope à force atomique. Ces instruments, combinés à la lithographie, permettent d'observer, de manipuler et de créer des nanostructures.

Les industries investissent massivement dans ce type de recherche, celles-ci étant pressenties pour ouvrir des horizons nouveaux aux biens manufacturés dans l'avenir.*

Où en sommes-nous '

La nanotechnologie est déjà à l'oeuvre dans les secteurs des cosmétiques, des composants informatiques, des crèmes solaires, des fenêtres auto-nettoyantes et des habits résistants aux tâches. Mais les matériaux utilisés à cette échelle ont des propriétés bien différentes de celles que peuvent avoir des macromatériaux.

Les experts ont préconisé le développement et l'usage d'instruments dans les 3 à 10 années prochaines afin d'évaluer l'exposition environnementale aux nanomatériaux. Des méthodes d'évaluation de la toxicité des nanomatériaux devront de plus être créées durant les 15 prochaines années.

Des modèles permettant de prédire leur impact sur la santé et l'environnement doivent impérativement être développés sur la prochaine décennie, afin de prévoir tous les différents scénarios possibles quant à leur utilisation.

" C'est donc une question qui dépasse la communauté scientifique, car elle nous concerne tous, dans nos habitudes de vie. Les gouvernements, les industries et les scientifiques du monde entier devront se poser la question de savoirs s'ils veulent developper (et rapidement) un usage prudent ou pas de la nanotechnologie " ont-ils ajouté.

Ce rapport a été décrit comme une référence dans l'histoire de la recherche en nanotechnologie par le président républicain de la division du comité scientifique de la chambre des députés américaine, Mr Sherwood Boehlert.

Il explique, dans un communiqué écrit en collaboration avec Bart Gordon, un démocrate du Tennessee que ce rapport " établit clairement les conséquences à prendre en compte et les priorités à mettre en place en ce qui concerne les dangers potentiels que représentent les nanotechnologies pour l'environnement et l'homme, et ceci sur une période de temps d'une dizaine d'années ".

Boehlert et Gordon ont exhorté le gouvernement américain à mettre en place un plan et un budget, qui seront nécessaires à l'application des recommandations contenues dans le rapport publié par les experts dans la revue Nature.

Ils ont fini en concluant que " Nous sommes exactement au bon moment aujourd'hui pour nous rendre compte des bienfaits et des besoins apportés par cette technologie. Si nous voulons continuer à bénéficier de ces avancées, il va falloir s'en préoccuper davantage " .Je viens tout juste de terminer un article sur les nanotechnologies publié dans le mensuel « Le Monde diplomatique » du mois de mars. Contrairement aux articles qu'on lit normalement, qui portent aux nues ce champ de recherche, celui-ci propose une discussion beaucoup plus pesée et critique. Il y a quelques semaines, on m'avait posé une question au sujet des dangers que pourraient comporter les nanotubes de carbone entre les mains d'un groupe de terroristes. J'avais alors répondu que leur prix était bien trop élevé pour qu'elles soient réellement utilisées par ces groupes. Malheureusement, il semble que les dangers puissent être plus grands dans une utilisation de tous les jours. On n'arrête pas le progrès...

L'expression « nanotechnologie » recouvre une gamme variée de systèmes et d'applications. Profitant des financements importants accordés dans le domaine, une bonne partie des physiciens de la matière condensée et des chimistes se sont rebaptisés nanoscientifiques. En effet, tout ce qui porte sur la fabrication de structures organisées sur une taille allant de quelques atomes à quelques dizaines d'atomes entre dans cette catégorie. Ceci inclut la fabrication de molécules un champ qui définit la chimie traditionnelle dans son ensemble, mais aussi de nouveaux domaines basés sur l'auto-assemblage, par exemple.

Ainsi, la fabrication de circuits électroniques de plus en plus petits, bien qu'atteignant des tailles nanométriques (la prochaine génération de puces sera composée de fils de 90 nm de large), n'est pas à proprement parler de la nanotechnologie. Tour de force technologique, il n'en reste pas moins que les techniques utilisées ne sont que des raffinements de méthodes en place depuis de nombreuses années. Nulle part ne fait-on appel à de nouvelles propriétés des semi-conducteurs qui pourraient dominer à cette échelle; au contraire, on continue de penser ces circuits avec les mêmes modèles que ceux utilisés pour des circuits 10 ou 100 fois plus gros.

La situation est similaire lorsqu'on parle de nanotubes de carbone ou de nanograins d'oxyde de titane. Pour beaucoup d'applications, ces matériaux sont utilisés essentiellement pour leurs propriétés classiques, telles que la rigidité ou leurs propriétés optiques. Il s'agit bien plus d'une chimie classique que de la fabrication de structures dont les propriétés dépendent intrinsèquement de leur petite taille. Là où ça se gâte, c'est qu'on ne connaît pas généralement l'impact de ces structures sur l'environnement ou sur le vivant. Ainsi, il est possible que ces structures très petites, mais inorganiques puissent se loger dans les alvéoles pulmonaires ou même traverser les barrières qui protègent le cerveau. La nouveauté est vraiment qu'on relâche dans l'environnement de nouvelles formes dont on connaît très peu les propriétés. Déjà, tel que cité dans le Monde diplomatique, certaines études suggèrent que ces nanoparticules peuvent traverser la barrière placentaire, et donc pourraient affecter les fétus.

Les dangers sont certainement bien moindres lorsqu'on considère des nanostructures intégrées à des objets macroscopiques. Ainsi, on travaille présentement au développement de surfaces de puces de silicium ou d'autres matériaux nanostructurés sur lesquels on pourrait déposer des molécules organiques afin de créer des interfaces organo-électroniques. Comme la puce elle-même est macroscopique (typiquement une taille de plusieurs mm), il n'y a pas de danger qu'elle disparaisse dans l'environnement. Quant aux nanorobots ou nano-outils, encore une fois, les risques apparaissent surtout si les objets se présentent sous forme de poudre plutôt qu'intégrées à de grands systèmes et, surtout, parce qu'on ignore généralement comment ces objets vont réagir dans l'environnement chimiquement varié que représente notre écosystème.

Il ne fait aucun doute que ces nouvelles technologies doivent être testées avec soin avant de les produire sur de grandes échelles. Les scientifiques qui les développent n'ont souvent pas la formation nécessaire pour faire ces tests et tendent à travailler dans des environnements très contrôlés et protégés afin, en général, d'éviter de contaminer leurs échantillons. Le gouvernement doit certainement mettre des normes en place afin d'obliger des tests toxicologiques sur chacun de ces produits ou simplement étendre celles qui devraient l'être lorsqu'on décide d'utiliser tout nouveau produit chimique ou biologique.

Ni plus, ni moins.

-

Compte tenu des corrections traditionnellement appliquées aux calculs astrologiques en raison de la précession des équinoxes, la plupart des astrologues estiment que l'entrée définitive du point vernal dans la constellation du Verseau pourrait ne pas intervenir avant encore au moins 200 années. Mais il existe désormais un nouveau courant d'astrologie spiritualiste, selon lequel l'année 2012 serait une année charnière décisive, et sans doute même celle de l'avènement effectif de l'Ère du Verseau.

La première décennie du Troisième Millénaire est une période très particulière, une période où chacun va devoir se préparer intensément, car un bouleversement majeur pourrait intervenir en 2012, année qui marquerait ainsi pour l'humanité le verrouillage définitif d'une très longue Ère de préparation, de maturation, puis d'accélération en vue du démarrage d'une nouvelle phase d'expérimentation.

Selon l'ancien calendrier Maya, nous atteindrons alors la fin d'un cycle de 26.000 ans. Puis viendra le Changement d'Âge, le temps de la grande Transition vers ce que les Mayas appelaient ''l'Âge Itza,'' un âge de Lumière et de Sagesse dans la conscience de la multidimensionnalité.

Coïncidence ou non ? à Fort Lauderdale, en Floride, un groupe d'astrophysiciens a récemment mis en évidence que la Terre était en ce moment même en train d'achever sa révolution autour du Soleil central de notre galaxie, qui dure elle aussi 26.000 ans. Ils ont associé à cette fin de cycle un phénomène générateur de perturbations électromagnétiques et cosmo-telluriques gigantesques qu'ils ont identifié sous le nom ''d'effet de tressaillement'' (wobble effect) et qui est supposé précéder de quelques années seulement l'amorce d'une nouvelle révolution.

Certains se souviennent peut-être également de ces intenses journées des 16 et 17 août 1987 qui marquèrent la première grande méditation mondiale pour la paix. Cette manifestation, baptisée à l'époque ''Convergence Harmonique,'' avait justement été organisée pour inaugurer les 26 dernières années de ce cycle de 26.000 ans.

Car cette ultime millième fraction de cycle que nous avons abordée est probablement la période la plus cruciale que l'humanité ait eue à affronter depuis bien des éons. Les mini-bouleversements que nous subissons aujourd'hui ne sont à l'évidence que les premiers soubresauts liés à cette fin de révolution cosmo-planétaire, et au-delà, toutes les données géo-biologiques risquent de s'en trouver profondément affectées. À partir de la fin de lannée 2012 en effet, et en même temps que le point vernal pénétrera dans la constellation du Verseau pour une période de 2.167 années, nous entamerons le nouveau cycle, où tout devrait être différent et où la vie elle-même devrait vibrer selon un rythme que nous avons encore du mal à concevoir.

La décennie que nous venons d'aborder est donc une période de purification et d'accélération vibratoire pour toute l'humanité. C'est aussi un temps d'éveil, au cours duquel nous devrions accéder progressivement à une autre réalité, commencer à intégrer nos corps de Lumière et réactiver nos aptitudes télépathiques naturelles, afin de pouvoir entamer, le 21 décembre 2012, ce nouveau cycle dans les meilleures conditions. Car, à partir de cette date, rien ne sera sans doute plus jamais comme avant...

Conférencier, auteur et guide sur les sites sacrés de part le monde, Gregg Braden a été reçu aux quatre coins de la planète après la publication de ses livres ''l'Éveil au Point Zéro : l'Initiation collective'', et ''Marcher entre les mondes.''

Après avoir connu dans sa jeunesse deux expériences de mort imminente (NDE), et mené une brillante carrière professionnelle d'ingénieur aérospatial, il s'est établi dans les montagnes du nord du Nouveau Mexique où il réside entre ses voyages et les séminaires qu'il anime dans tous les États-Unis.

Gregg Braden voyage à travers le monde entier. Il a apporté la preuve scientifique du passage de la Terre à travers la ceinture de photons et du ralentissement progressif du rythme des rotations de la Terre. En même temps, il est parvenu à démontrer scientifiquement l'accélération de la fréquence de résonance de la Terre (Résonance Schumann).

Selon lui, quand la Terre arrêtera ses rotations et que la fréquence atteindra 13 cycles (13 Hz), nous serons au ''Point Zéro'' du champ magnétique. La Terre s'immobilisera et au bout de deux ou trois jours, elle commencera à tourner dans l'autre sens. Cela produira un renversement dans le champ magnétique autour de la Terre et en elle.

Gregg Braden en tire une série de conséquences :

1/ Le temps va paraître de plus en plus rapide au fur et à mesure que nous approcherons du ''Point Zéro''. Actuellement la Terre atteint 12 cycles (12 Hz) et devrait théoriquement s'arrêter à 13 cycles (d'où la symbolique du chiffre 13). En provoquant le renversement des pôles magnétiques, la traversée du Point Zéro précipitera probablement l'ensemble de l'humanité dans la quatrième dimension (qui n'est elle-même qu'un point de transit vers la cinquième). À ce stade, chaque chose que nous penserons ou désirerons se manifestera instantanément. Le Point Zéro sera probablement atteint sous peu, dans les toutes prochaines années, sans doute avant la fin de l'année 2012. Vers 2013, nous entrerons dans la cinquième dimension (après le saut dans la quatrième dimension, au Point Zéro).

2/ Le changement d'Âge au Point Zéro, prédit par différents peuples depuis des milliers d'années est donc sur le point de se réaliser. Il y a eu de nombreux autres changements d'Ère avant celui qui nous préoccupe, mais aucun n'a été aussi radical que celui qui vient. Ces bouleversements interviennent toujours chaque 13 000 ans, soit la moitié de 26 000, ce qui équivaut à une révolution complète du Soleil autour du Soleil Central de notre galaxie.

3/ Tout laisse supposer qu'après le franchissement du Point Zéro, le Soleil se lèvera à l'ouest et se couchera à l'est. Différents textes anciens, dont l'authenticité ne peut être mise en doute, témoignent de l'existence de tels bouleversements dans le passé lointain de l'humanité.

4/ Les énergies qui président à l'établissement d'un Nouvel Ordre Mondial - les énergies liées au Verseau et aux planètes trans-saturniennes - seront à leur plus haut potentiel en 2003. Mais leur influence dépendra de différents facteurs et notamment de l'utilisation faite par l'humanité de son libre-arbitre.

5/ La plupart des technologies que nous connaissons cesseront bientôt d'être opérationnelles. L'exception pourrait être celle de l'énergie libre déjà imaginée par Tesla il y a plus d'un siècle, proposée à différentes reprises à certains de nos gouvernements par des extraterrestres, mais interdite et occultée par le gouvernement mondial jusqu'à ce jour. Le Calendrier Maya avait prédit tous ces changements qui arrivent maintenant. Les Mayas avaient prévu que nous irions au-delà de nos technologies et que nous reviendrions aux cycles naturels basés sur l'Harmonie Universelle.

Toutes ces informations ne sont pas effrayantes ; préparons-nous joyeusement aux changements qui arrivent, puisqu'ils amènent le Nouvel Âge de la Lumière.

Voici un court message de Kryeon canalisé en 1999 par Lee Carroll, qui concerne les années que nous sommes en train de traverser et l'échéance de 2012 :

'' Vous savez, vous êtes engagés dans une lutte qui ne cessera pas au cours des prochains mois ou des quelques années à venir. Il existe une énergie yin et une énergie yang ; elles se débattent pour trouver un équilibre. Le paradigme de l'existence sur cette planète - sur les plans physique, mental et spirituel - est véritablement en train de se transformer sous vos pieds. Vous-mêmes êtes en train de changer et la Terre change aussi grâce à votre illumination et à la transformation de votre conscience. Mais beaucoup d'entre vous ne comprennent pas exactement de quoi il retourne réellement.

Vous parvenez à la fin de très longues épreuves que vous avez vous-mêmes créées. La plupart de ceux qui, autour de vous, firent certaines prédictions, annoncèrent ''la fin du monde''. Ils mirent régulièrement l'accent sur certaines dates et périodes bien spécifiques. Vos anciens prophètes l'ont fait, vos contemporains l'ont fait, les Observateurs à distance l'ont fait et, en général, un consensus semble s'établir entre eux, en particulier pour les années allant jusqu'en 2012.

Cependant, vous récoltez aujourd'hui les fruits du nouveau message qui vous a été offert par la Famille au cours des dernières années, et vous avez modifié votre futur. Vous aviez planifié que votre retour au Foyer passerait par une fin tragique. Mais le test qui vous est proposé n'aura pas pour but de vous détruire. Une nouvelle énergie vous permettra de parvenir à la fin de ce test et d'aller au-delà en votre qualité d'êtres humains, d'atteindre ainsi une vibration dont vous ne pensiez pas pouvoir faire l'expérience, compte tenu de votre vécu des derniers siècles.

La période s'étendant d'aujourd'hui à 2012 ne signifiera pas la fin de la planète mais, au contraire, le début d'une nouvelle Ère. Année après année, vous constaterez des changements de potentialité. En fait, il s'agit d'une période essentielle pour vous.

Cette période transitoire entraînera toutefois des difficultés à surmonter. Au cours des années qui viennent, vous allez devoir affronter une lutte entre l'ancienne énergie et la nouvelle. Mais le triomphe est désormais à votre portée. ''

Quel avenir pour l'humanité au-delà de 2012

Conférencier, auteur de ''Les Dernières Pièces du Puzzle'' et de ''À la recherche du message des Dauphins'' (Éd. Communicare), Claude Traks parcourt inlassablement la planète depuis des années, pour expliquer à ceux qui veulent bien lentendre quelles sont les conditions que lhumanité doit remplir pour éviter que les plus terribles prédictions de lApocalypse ne se réalisent au cours de la décennie qui vient de commencer et pour que nous puissions tous accéder à la Nouvelle Époque.

Conférencier, auteur de ''Les Dernières Pièces du Puzzle'' et de ''À la recherche du message des Dauphins'' (Éd. Communicare), Claude Traks parcourt inlassablement la planète depuis des années, pour expliquer à ceux qui veulent bien lentendre quelles sont les conditions que lhumanité doit remplir pour éviter que les plus terribles prédictions de lApocalypse ne se réalisent au cours de la décennie qui vient de commencer et pour que nous puissions tous accéder à la Nouvelle Époque.

Voici quelques extraits de son interview accordée en octobre 2002 au mensuel gratuit Soleil Levant.

( ) " Il y a actuellement une montée dénergie qui est très claire et qui est reconnue même par la NASA. Pour x raisons, la fréquence de la Terre (liée à la résonance de Schumann) est en train daugmenter. Cette fréquence influence tout le monde et toutes les situations : les moments damour, les moments de non amour. Cette énergie va culminer en 2012. Je ne sais pas si à cette date on sera tous éveillés et pleins damour, je nen sais rien ! En tous cas, cest ce que beaucoup de traditions affirment ! Personnellement, je crois que le changement aura lieu plus tôt.

( ) Mes conférences ont pour thème : « objectif 2012 : une humanité humaine. » Il sagit dun objectif à la fois écologique et social.

- Il est dabord écologique, car nul na besoin de croire en Dieu pour comprendre que si lon continue à polluer la planète, rien nira plus.

Jai eu accès à des rapports des Nations Unies qui affirment radicalement quen 2008-2010, toutes les voitures devront fonctionner à autre chose quau pétrole, que lénergie nucléaire devra définitivement faire partie du passé ; sinon aucun avenir ne sera plus envisageable pour la planète.

- Objectif social, car il faut partager les ressources avec les autres, ne serait-ce que pour notre propre survie ! À savoir que si les inégalités sociales continuent de saggraver, le peuple descendra dans la rue et les gouvernements deviendront répressifs : on vivra dans des dictatures. Il y aura des chars à chaque coin de rue pour nous museler.

Le gouvernement mondial en place nous manipule pour mieux nous éloigner du divin en nous, il crée en nous la peur du manque et donc le non-partage ! Il y a pourtant sur Terre suffisamment de ressources pour nourrir tout le monde !

Le gouvernement mondial est un « organisme » secret composé des 200 familles les plus riches du monde, qui détiennent, à travers des prête noms et des sociétés écrans 98 % des richesses sur Terre. Il ne faut pas se leurrer, ils élisent à coût de millions de dollars les présidents qui, aujourdhui sont plus des businessmen obsédés par largent que des êtres préoccupés de lévolution du monde. Ces personnes sont en permanence les jouets dêtres invisibles qui les tirent dans tous les sens et lobjectif des « formes pensées » quils propagent est de détruire lhumanité avant léveil de sa conscience. ( )

Heureusement lespèce humaine a des pouvoirs énormes. Chacune de nos pensées, chacun de nos choix a des répercussions à linfini, dans toutes la création, toutes les dimensions et toutes les planètes. Comme les humains sont très puissants et aussi très inconscients, ils sont donc très dangereux. Sil y a trop dexcès, il est normal quune force extérieure vienne rétablir léquilibre ( )

Ce quil est important de retenir, cest que lon vit un moment crucial. Que lon soit athée ou croyant, cela na pas dimportance. Aujourdhui, chacun de nos choix individuels va nous rapprocher un peu plus dun monde extraordinaire ou tout simplement de notre destruction : ce sont les individus qui feront la différence.

Il est donc vital et primordial que les gens vivent leurs rêves et vivent la vie quils ont toujours rêvée. Il ny a plus de temps à perdre.

Cest très simple : soit les êtres se mettent au service de lamour, comme au service dun employeur, en lui consacrant au moins 51 % de leur énergie, soit ils passent 51 % de leur temps à être employés de ce système assassin et dévastateur, ce qui nous conduira à la destruction. Le but nest pas dêtre intégriste mais amour à 51 %.

Pour y arriver, ce nest pas du tout compliqué. Il nous suffit de regarder qui lon fréquente, quels livres on lit, où lon fait nos courses, quest-ce que lon mange, quest-ce que lon regarde à la télé Chacun de nos choix a des répercussions sur le reste de la création. Aujourdhui il faut en prendre conscience et agir en conséquence.

Sur Terre nous sommes libres de nos choix, mais jamais nous ne serons libres des conséquences de nos choix. "La Prophétie de Daniel et "le Temps de la Fin".

Peu de temps avant sa mort il y a près de 60 ans, le grand clairvoyant Peter Deunov a révélé que, dans lAncien Testament de la Bible, les chapitres 11 et 12 du Livre de Daniel concernent lépoque que nous traversons aujourdhui (et qui sachèvera peut-être à la fin de lannée 2012 - Cf. nos pages : La dernière Prophétie de Peter Deunov, Lévacuation planétaire de décembre 2012, Les événements jusquen décembre 2012 et Les 3 vagues dAscension).

À la fin de son livre « Eau Diamant, une Conscience », principalement consacré à la présentation de sa méthode qui permet dencoder leau et den faire un puissant agent de réalignement des énergies, tout en rendant son principe harmonisant multipliable à linfini, Joël Ducatillon (autodidacte de génie et également médium à ses heures) raconte quune nuit daoût 1994, la voix de son guide intérieur sest adressée à lui avec une grande clarté.

Après lui avoir murmuré : « Relis la prophétie qui concerne le Roi du Nord et le Roi du Sud (celle du prophète Daniel), car elle concerne lépoque qui commence maintenant ! », elle lui fit comprendre que « le Roi du Sud » désigne les mouvements fondamentalistes religieux et les combattants de lIslam, et que « le Roi du Nord » représente lensemble des états occidentaux dont lAmérique est le chef de file.

Le Prophète Daniel

La partie de la prophétie qui a trait au « temps de la fin » démarre au verset 40 du chapitre 11 du Livre de Daniel et se termine à la fin du chapitre 12 (le dernier chapitre). Le verset 40 explique que les forces du Roi du Sud vont commencer par harceler le Roi du Nord, et que celui-ci déferlera alors sur le Roi du Sud avec sa puissante armée.

Il y est écrit : « Au temps de la fin, le Roi du Midi se révoltera contre le Roi du Nord, (allusion sans doute à la révolte des mouvements intégristes musulmans contre lhégémonie américaine et aux attentats du 11 septembre 2001) et le Roi du Nord fondra sur lui comme une tempête, avec des chars et des cavaliers et avec beaucoup de navires, pénétrera dans les terres et passera outre (Ce « passera outre » peut fort bien vouloir dire : « ne tiendra pas compte des mises en garde de nombreux gouvernements et de la réprobation de limmense majorité des populations de la Terre »). Et il viendra dans le pays de beauté. (ce que lon peut traduire par lIrak, car jadis, à lépoque de la Chaldée et de Sumer, Babylone (située à quelques dizaines de kilomètres au sud de Bagdad) était célèbre pour la beauté de ses jardins suspendus et la splendeur de son architecture, et la Mésopotamie (lIrak actuel) pour ses merveilleuses palmeraies qui sétendaient à perte de vue entre les rives fleuries du Tigre et de lEuphrate. Certaines traditions situent lÉden, le paradis terrestre, dans la vaste région sétendant de la Mésopotamie à lArabie, dont la limite sud est le golfe dAden. Aden et Éden ont dailleurs étymologiquement la même racine.) »

Il semble donc logique den conclure que la période nommée « temps de la fin » soit à présent commencée, puisque linvasion de lIrak par larmée américaine à laquelle se réfère de toute évidence ce verset, sest effectivement produite au début de lannée 2003.

Peu de temps après quil eût été donné à Joël Ducatillon de comprendre que la prophétie de Daniel débuterait par cet événement, un autre message lui annonça ceci : « Un homme important sera assassiné. Cet événement marquera linstallation de la Chose immonde qui cause la dévastation et la cessation du Sacrifice perpétuel. »

Quest-ce que « le Sacrifice perpétuel » ? Dans la tradition biblique, kabbalistique et théosophique, « le Sacrifice perpétuel » est luvre de lÊtre de la Terre, autrement dit : du Roi du Monde, celui que les Orientaux nomment Markandé et les Chrétiens Melchitsédek. Dans son Épître aux Hébreux, Saint-Paul dit de cet Être qu'Il est « sans père, sans mère, sans généalogie, qu'Il na ni commencement ni fin de sa vie, qu'Il est ainsi rendu semblable au Fils de Dieu et quIl est Sacrificateur à perpétuité. » (Cf. notre page consacrée à lénigme du Roi du Monde.) Il est par ailleurs écrit dans le Nouveau Testament que Jésus était « de lOrdre de Melchitsédek », ce qui sous-entend implicitement que Melchitsédek assume au sein de la Hiérarchie spirituelle de la Terre un rang plus élevé que celui occupé jadis par Jésus (ou aujourdhui par Sananda).

Une « Chose immonde » pourrait donc être prochainement la cause de linterruption temporaire du travail de lÊtre de la Terre, qui consiste à se sacrifier à perpétuité pour que notre planète puisse conserver son équilibre vital et continuer à subvenir aux besoins vitaux de ses habitants. LÊtre de la Terre offre son corps et le sacrifie à lhomme pour que chacun des quatre grands règnes de la nature puisse continuer à évoluer. Linterruption de cette mission devrait évidemment entraîner de nombreux cataclysmes ! Ce sont ces cataclysmes, ces tribulations qui seraient ainsi évoquées à la fin du chapitre 11 et au début du chapitre 12.

On peut évidemment se perdre en conjectures sur linterprétation quil convient de donner à cette « Chose immonde » à lorigine de la dévastation de la Terre (arme nucléaire, chimique, bactériologique ou autre charmante invention de lhomme ?), de même que sur le nom du personnage lié à cette prophétie et appelé, selon le guide de Joël Ducatillon, à être prochainement assassiné. Il semble cependant assez logique de voir dans le Léviathan, qui symbolise la Chose immonde, légrégore incarnant luvre du gouvernement mondial et des Illuminati, à loccasion dun ultime accès de mégalomanie destructrice, dont ils seraient secrètement (ou cette fois publiquement) à lorigine.

Selon la tradition kabbalistique et apocalyptique, le Léviathan, personnification de « la Chose immonde », surgit des abysses sub-océaniques au cours du « Temps de la Fin » (image ci-dessus), amenant la désolation à la surface de la Terre, mais cet égrégore est finalement vaincu par celui que Daniel nomme « Mikhaël, le Grand Chef » (image ci-dessous).

La fin de la prophétie (Chapitre 12, versets 11 à 13) dit exactement ceci : « À partir du temps où le Sacrifice perpétuel sera suspendu et où lAbomination qui désole sera installée, il y aura 1290 jours. Bienheureux celui qui attend et qui parvient à 1335 jours ! Et toi, va jusquà la fin. Tu seras dans la paix et tu te tiendras dans ton lot si tu parviens à la fin des jours. » (Ce qui signifie vraisemblablement : tu seras alors prêt à hériter de ta véritable condition dHomme.)

Si lon sen tient au texte de la prophétie, il y aura donc 3 années et demi dépreuves terribles pour lensemble de lhumanité (1290 jours), suivies de 1 mois et demi de bouleversements planétaires (45 jours supplémentaires) avant la fin des jours.

Le 21 décembre 2012 étant la journée marquant la fin du grand Cycle actuel selon le calendrier maya (Cf. notre page consacrée à Carlos Barrios et au calendrier maya), et celle de lévacuation de la Terre selon Ashtar Sheran et de nombreuses sources télépathiques, on peut samuser à faire un petit calcul : trouver le jour J moins 1335 ! Cela nous amène au 25 mars 2009.

Cest donc au printemps 2009 que pourraient commencer les ultimes tribulations avant lavènement de lÈre Nouvelle.

Il nous resterait alors environ 5 années à vivre dans des conditions proches de celles que nous connaissons aujourdhui. Puis viendrait le véritable « commencement de la fin. »

Tout ceci ne constitue bien sûr quune succession dhypothèses plus ou moins crédibles. Car après tout, peut-être Daniel nétait-il pas un grand prophète ! Peut-être Peter Deunov nétait-il pas un véritable Maître spirituel ! Peut-être Joël Ducatillon sest-il laissé abuser par de petits farceurs du bas-astral (car certaines entités qui vivent dans ce plan prennent parfois plaisir à taquiner les humains) ! Et peut-être que le 21 décembre 2012, il ne se passera tout simplement rien de plus ni rien de moins que nimporte quel autre jour !

Mais sils avaient raison, si les Mayas avaient raison, si lastrophysicien Gregg Braden et lélite scientifique actuelle avaient raison à propos du passage au « Point Zéro » en 2012, si David Wilcock et les plus grands télépathes du monde entier avaient eux aussi raison, alors il ne nous resterait peut-être plus que 5 années avant que « la Chose » ne déverse son abomination sur notre planète, 5 années au cours desquelles il est encore temps de se préparer, de renoncer une bonne fois pour toutes à tout ce qui a alourdi notre encombrant fardeau karmique à travers les siècles et les millénaires, temps de demander de tout son cur, de toute son âme et de toutes ses forces que les conditions de lavènement de la Fraternité et de lÂge dOr se réalisent le plus tôt possible sur notre planète, et que le Roi du Monde puisse enfin se manifester non plus en tant que Sacrificateur, mais en tant que Libérateur.Sources : http://www.erenouvelle.com